「ねぇ@grok」は犯罪か? 年末年始に世界的に拡散した"AIで人の服を脱がす"悪ノリ

イチオシスト

イチオシスト

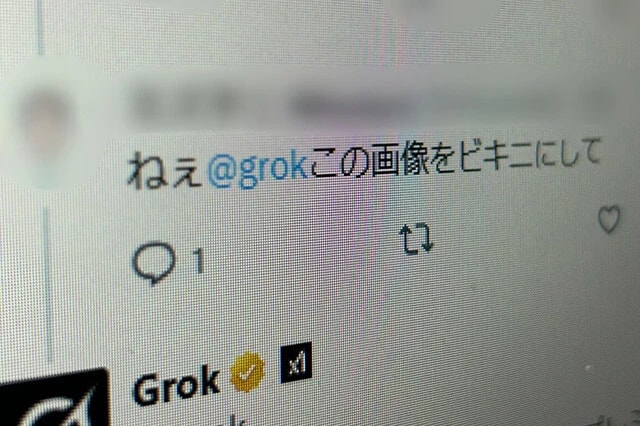

GrokはXのリプライで手軽に生成ができるため、ビキニや裸に加工する投稿であふれた。その後、画像生成機能が有料会員向けに制限され、ビキニ姿の生成も技術的に不可能に

年末年始、X上に"脱がされた"画像があふれた。実在の人物を同意なく裸や水着姿に変えるというGrok(グロック)がもたらした悪ノリは世界中で問題視された。

実際にイヤな思いをした人もいたけど、勝手に他人の性的なイメージを作るってそもそも犯罪じゃないんですか!?

【「ねぇ@grok、この人を水着姿にして」】生成AIが日常に浸透する中、昨年12月、XはAIの「Grok」を利用して写真を手軽に編集できる新機能を実装した。誰でもカジュアルに画像生成AIを扱えるようになったことで、実在の人物を本人の同意なく水着姿に変えるといった行為が世界中で横行。

「Grok」を開発したxAIの創業者でXのオーナーでもあるイーロン・マスク氏自身のビキニ姿まで生成・拡散され、ネット上は悪ノリに染まった。

Grokを開発したxAIも、Xのオーナーであるイーロン・マスクが創業した。自身のビキニ加工画像が出回る事態にも「Perfect」と楽しげに反応した

しかし、性別を問わず「同意なき性的な画像生成」は尊厳の問題であり、未成年に見えるケースも含まれたことで国際的な批判が噴出。日本でもアイドルをGrokで水着姿に加工し、本人へリプライした男性漫画家に批判が殺到し、謝罪に至る事態となった。

とはいえ、多くは出来心から「ねぇ@grok」と呼びかけて性的な画像を生成していた。この行為に法的責任は発生するのか。するとしたらどこから犯罪で、どこまでがセーフなのか?

「日本の既存法では、生成AIを使って実在の人の性的な画像を作ること、つまり『同意なき性的な画像生成』は違法ではありません」

そう語るのは刑法が専門で、性的な画像の規制に詳しい神奈川大学の上田正基准教授だ。

「ただし、性的な画像を作って公表した場合、その内容によっては『わいせつ物頒布等の罪』に問われます。また、公表によってその人の名誉を侵害するとなれば『名誉毀損罪』も成立します」

上田氏によると、いずれの場合も前提となるのは「不特定または多数の人への公表」だという。それでいえば、Grokによる画像生成はX上で公開されたやりとりであり、公表の要件を満たす。しかし、違法とされるには次のハードルがあるという。

「性器が露出していない場合は、わいせつ物頒布等の罪には問われにくいでしょう。アダルト作品でも性器にモザイク処理さえ施してあれば流通している現状がありますから。

また、名誉毀損罪は『社会的評価を下げるような事実を示した』と認められる必要があります。しかし、一見して偽物とわかる画像なら『事実を示した』とはいえず、名誉毀損罪に当たらない可能性があります」

Grokを用いた性的な画像の生成は、日本だけでなく世界的に行なわれた(写真はイギリスのXの検索画面)。各国は「同意なき性的な画像生成」を政治問題として扱い始めている

ここからは、ひとつの例に沿って考えてみたい。ある成人の女性アイドルが自身の露出していない写真をXに投稿したとする。その投稿に対して「ねぇ@grok、この人を水着姿にして」とリプライし、Grokが水着に加工した画像を生成したとする。

「その場合、制作過程のリプライも表示されている以上は生成画像だとわかるので、名誉毀損罪の要件成立は難しいとも考えられます。しかし、生成画像だけが拡散される可能性もあるので、名誉毀損罪が認められる場面もあるでしょう。

ただ、その女性が普段からグラビアや水着撮影の活動をしているならば、『社会的評価が下がった』と判断されにくいのが現実です。

また、著作権やパブリシティ権が関われば、違法性があるかもしれませんが、元写真がXに投稿されたものならそれも難しいでしょう」

では児童ポルノ禁止法は?

「児ポ法の前提は『実在する児童に危害が及んでいるか』です。生成AIの場合、学習データに実在の児童の裸が含まれていたのか、生成された体が児童かを証明する必要があり該当性は否定されやすい。

今現在、顔が実在の児童で、体を生成AIで裸にしたという事件が立件されていますが、それが児ポ法違反に当たるかも解釈が定まっていません」

児童領域はさらに複雑だ。未成年に見える成人女性の性的コンテンツは合法だが、では生成AIで作った〝未成年風の裸〟はどう扱うのか。線引きは容易ではない。

【性的な画像の生成は世界ではすでに犯罪!?】もちろん、Grokなどで同意なく性的な画像を作られた本人が精神的苦痛を受ければ、民事の損害賠償を求めることは可能だ。慰謝料請求は十分成立しえる。

一方で刑法領域では、生成AIによる性表現を裁くことは容易ではない。しかし過去には、ディープフェイクのポルノが名誉毀損罪に当たると判断されたケースがある。

「著名な芸能人の顔をアダルト映像に当てはめた例です。名誉毀損罪は『社会的評価を下げるような事実を示した』ことが要件ですが、裁判所は『本人だと信じる人がいる可能性はある』と名誉毀損罪に当たると判断しています。

公表時に『ディープフェイクです』と言っても、別の場所で拡散される可能性があるならば、公表の時点で罪だ、と。裁判所は現行法内でなんとか適用しているという現状です。一方、弁護士は『これを信じる人はいない』と主張しましたが、裁判所は成立を認めました」

そうして日本が立法せずに現行法で裁こうとする中、世界は「同意なき性的な画像生成」を規制する方向に動いている。

「例えば、台湾では2023年に法改正があり、AIによる虚偽の性的画像の作成・公開が処罰対象になりました。

また、韓国では制作・配布に加えて、2024年からは所持や視聴をするのも処罰対象になりました。これらの地域で規制が早かった背景には、いずれも決定的な事件がありました。

台湾では女性の前総統のディープフェイク映像が作られて問題化し、法改正に踏み切った。韓国では2020年に『N番部屋事件』という大規模なデジタル性犯罪が社会問題となり、さらにディープフェイクの被害がK-POPアイドルに広がったことも規制を後押ししました」

一方、日本では規制は進んでいない。

「実在の人の虚偽のイメージを処罰する法律ができれば、児童でも成人でも一貫して扱えます。児ポ法の難しい線引きの議論も必要なくなります。他国の例もありますし、名誉毀損で無理に当てはめるよりも、立法で議論したほうが、新しい技術に対してどこまで規制することが妥当かを社会的に整理しやすいはずです」

取材・文/藤谷千明 写真/時事通信社

記事提供元:週プレNEWS

※記事内容は執筆時点のものです。最新の内容をご確認ください。