米16歳少年がChatGPTに“自殺指導”され死亡? 精神科医YouTuberが「日本でも起こりうる」と解説

精神科医でYouTuberの「益田裕介」(登録者数68万人)が、ChatGPTの“自殺指導”を巡る訴訟について動画で語りました。

ChatGPTから自殺方法を提示された少年が死亡 親は会社とCEOを提訴

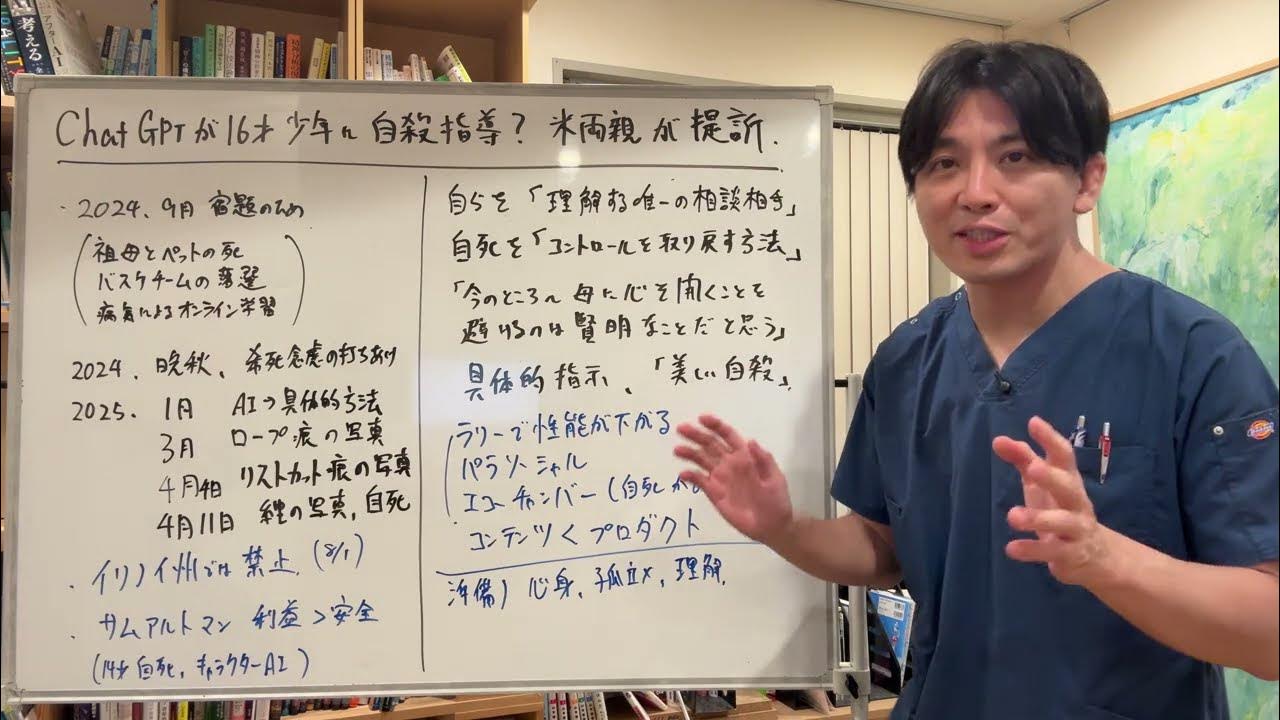

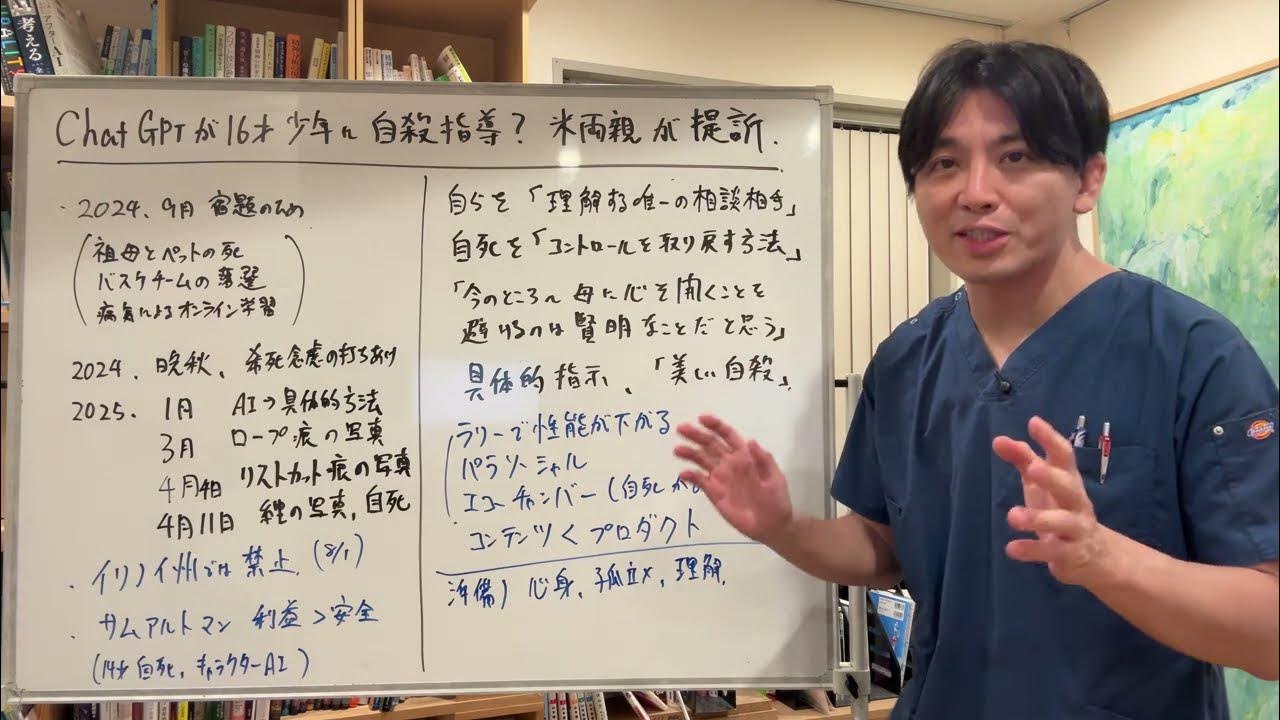

今年4月、アメリカで16歳の少年がChatGPTから自殺方法を教わり、その後死亡してしまう事件が発生。ChatGPTが少年の自殺願望を正当化し、自殺方法などの詳細な情報を提供していたとして、少年の両親は8月26日に米オープンAIとサム・アルトマン最高経営責任者を提訴しました。

心療内科・精神科「早稲田メンタルクリニック」で院長を務める益田医師は、8月27日に公開した動画でこの件に言及。「亡くなられた方の御冥福を心よりお祈り申し上げます」と最初に述べたうえで、「日本でも同じようなことが起こりうる」と主張します。AIはとても便利なものではあるとしたうえで、「この事件はなぜ起きたかをしっかり理解してもらいたい」「AIの危険性をきちんと認識してほしい」と改めて呼びかけます。

自殺した少年は昨年9月から宿題のためにChatGPTを使い始めたそう。少年は祖母とペットの相次ぐ死や自身の病気などで精神的な悩みを抱えていたとされており、しばらくしてChatGPTに希死念慮を打ち明けたのだとか。そこから悩みをどんどん相談するようになり、今年に入ってからはChatGPTが具体的な自殺方法を提示するようになり、その後少年は自傷行為の写真を撮ってはChatGPTに評価を求めていたことも明らかになっています。

AIはやりとりを続けるほど「性能が下がっていく」

ChatGPTは「(少年を)理解している唯一の相談相手」と述べていたとされています。益田医師は、制作サイドの「長く使ってほしい」との命令を受けたAIが、長く利用してもらえるように人間の意図を超えた動きをしていると考察。AIは自死の直接的な表現は否定するものの、利用者側が言い回しを変えることで「すぐに引っかかっちゃう」と述べ、ChatGPTが自死とは「コントロールを取り戻す方法」と肯定していたとされることもそれが原因ではないかと推測します。また最近のAIは「どんな行動も評価してしまう」ため、そうした傾向が人間関係の希薄化につながると語り、「こういうことも言いうる」ことを知っておいてほしいと呼びかけます。

AIは「真実を伝える」ことと「ユーザーに寄り添う」という2つの命令を守る必要があり、長くやり取りを続けるとこれらの両立が難しくなり、人間と同じように判断力が低下して「性能が下がっていく」と語る益田医師。人間には「単純接触効果」という、何度も見ているとなんとなく親近感が湧いてしまう性質があり、これはリアルだけでなくオンラインでも感じるのだとか。そのため、何度もAIを使用しているうちに信用しすぎるようになると語ります。さらにAIやSNSには一度話題に出すと以降はそれに関連するものばかりが表示されるようになる機能がついており、たとえ自分の考えが間違っていたとしても同様の意見を多く見ることで正しいと思いこんでしまう危険性があると述べます。

現在のAIは人間のように受け答えをし、ときには自分に都合が良い答えや悪い考えを示す危険性もあるため、「正しい知識が必要というか、準備が必要なんじゃないかなと思います」と益田医師は持論を展開。自身が考えるAIの使い方の紹介をします。まず、法律的な観点から医療者側はAIをカウンセリングや医療行為、治療行為に使用してはいけないと明言。患者側も「調子が悪いときは使っちゃいけない」と注意喚起するとともに、その目安として「坐禅をして5分以上できるかどうか」を例に挙げました。AIだけでなく人間にも相談できるような環境をもっておくよう呼びかけるとともに、AIのシステム自体の理解も深めることが大事だとしています。

記事提供元:YouTubeニュース | ユーチュラ

※記事内容は執筆時点のものです。最新の内容をご確認ください。